Catégories principales de métriques d’évaluation pour les systèmes de recommandation – 3ème partie

Autres métriques. Bien que les fonctions d’erreurs et les métriques d’aide à la décision soient importantes dans l’évaluation de la performance des systèmes de recommandation, il existe des aspects qui ne sont pas pris en compte par ces dernières [1]. Ainsi, de nouvelles mesures d’évaluation ont été proposées [2-5]:

- Couverture : la couverture mesure le pourcentage des articles pour lesquels le système a pu calculer des recommandations. Selon Miller et al. [6], il existe deux façons de calculer la métrique de couverture. La première calcule le pourcentage global des articles pour lesquels le système de recommandation a pu calculer des prédictions. La deuxième évalue le pourcentage des articles choisis par l’utilisateur pour lesquels le système de recommandation a pu calculer des prédictions [5, 7-12].

- Taux d’apprentissage : les algorithmes d’apprentissage sont une composante importante des systèmes de recommandation. Leur performance varie en fonction de la quantité de données d’apprentissage disponibles. Si la quantité de données d’apprentissage augmente, la qualité des recommandations devrait augmenter. Donc, cette mesure évalue la qualité des recommandations par rapport à la quantité de données d’apprentissage disponibles [2].

- Nouveauté et hasard (« Novelty and Serendipity ») : pour illustrer cette mesure, Ziegler [3] prend pour exemple l’achat de bananes dans une épicerie. Dû à la popularité élevée de ces dernières, la plupart des personnes les achètent intuitivement. Donc, ces personnes n’ont pas besoin d’une recommandation supplémentaire puisqu’elles savent déjà qu’elles vont acheter des bananes. Cette métrique mesure ainsi les recommandations non évidentes, tout en pénalisant celles évidentes [2, 13].

- Satisfaction des utilisateurs : les travaux de Cosley et al. [14] montrent que la satisfaction de l’utilisateur diminue quand un nombre significatif d’erreurs est produit par le système de recommandation. Ainsi, il peut être possible d’établir, très facilement, le niveau de satisfaction des utilisateurs [6, 14].

- Similarité moyenne : cette mesure, introduite par Miller [4], s’intéresse à la qualité du voisinage. Plus précisément, la similarité moyenne est une mesure qui évalue la similarité moyenne du groupe d’utilisateurs choisis pour le calcul de la recommandation finale [6].

- Ressources utilisées : cette dernière s’intéresse à la complexité de l’algorithme de recommandation. En effet, cette mesure calcule les ressources consommées par l’algorithme. Plus précisément, les ressources considérées peuvent être le temps de réponse, la consommation de ressources systèmes, etc. [4, 6].

Références

[1] S. M. McNee, J. Riedl, and J. A. Konstan, « Being accurate is not enough: how accuracy metrics have hurt recommender systems, » CHI ’06: CHI ’06 extended abstracts on Human factors in computing systems, pp. 1097-1101, 2006.

[2] L. J. Herlocker, A. J. Konstan, G. L. Terveen, and T. J. Riedl, « Evaluating collaborative filtering recommender systems, » ACM Trans. Inf. Syst., vol. 22, pp. 5-53, 2004.

[3] C.-N. Ziegler, « Towards Decentralized Recommender Systems, » Albert-Ludwigs-Universitat Freiburg – Fakultat fur Angewandte Wissenschaften, Institut fur Informatik, 2005.

[4] N. B. Miller, « Toward a personal recommender system, » University of Minnesota, 2003, p. 185.

[5] G. Adomavicius and A. Tuzhilin, « Toward the next generation of recommender systems: a survey of the state-of-the-art and possible extensions, » Transactions on Knowledge and Data Engineering, vol. 17, pp. 734-749, 2005.

[6] B. N. Miller, J. A. Konstan, and J. T. Riedl, « PocketLens: Toward a personal recommender system, » ACM Trans. Inf. Syst., vol. 22, pp. 437-476, 2004.

[7] P. Massa and P. Avesani, « Trust-Aware Collaborative Filtering for Recommender Systems, » On the Move to Meaningful Internet Systems 2004: CoopIS, DOA, and ODBASE: OTM Confederated International Conferences, CoopIS, DOA, and ODBASE, vol. 3290, 2004.

[8] J. L. Herlocker, « Understanding and improving automated collaborative filtering systems, » University of Minnesota, 2000, p. 144.

[9] Z. Zaier, R. Godin, and L. Faucher, « Recommendation Quality Evolution Based on Neighborhood Size, » in Third International Conference on Automated Production of Cross Media Content for Multi-Channel Distribution. AXMEDIS ’07 Barcelona, Spain, 2007, pp. 33-36.

[10] Z. Zaier, R. Godin, and L. Faucher, « Recommendation Quality Evolution Based on Neighbors Discrimination, » in MCETECH Conference on e-Technologies Montreal, 2008, pp. 148-153.

[11] N. Good, B. J. Schafer, J. A. Konstan, A. Borchers, B. Sarwar, J. Herlocker, and J. Riedl, « Combining collaborative filtering with personal agents for better recommendations, » AAAI ’99/IAAI ’99: Proceedings of the sixteenth national conference on Artificial intelligence and the eleventh Innovative applications of artificial intelligence conference innovative applications of artificial intelligence, pp. 439-446, 1999.

[12] S. E. Middleton, N. R. Shadbolt, and D. C. De Roure, « Ontological user profiling in recommender systems, » ACM Trans. Inf. Syst., vol. 22, pp. 54-88, 2004.

[13] G. L. Terveen and W. Hill, « Beyond Recommender Systems: Helping People Help Each Other, » in Human-Computer Interaction in the New Millenium, J. M. Carroll, Ed. Reading, MA, USA., 2001.

[14] D. Cosley, S. K. Lam, I. Albert, J. A. Konstan, and J. Riedl, « Is Seeing Believing? How Recommender Interfaces Affect Users’ Opinions, » in CHI Lett. vol. 5, A. Press, Ed., 2003, pp. 585-592.

Catégories principales de métriques d’évaluation pour les systèmes de recommandation – 2ème partie

Métriques d’aide à la décision. Ces métriques sont, généralement, utilisées dans l’évaluation des systèmes de repérage d’informations. À l’opposé des fonctions d’erreurs, les métriques d’aide à la décision n’évaluent pas la qualité de la prédiction, mais la pertinence des documents. Ainsi, ces mesures prennent seulement en considération la pertinence du document [1-5]. Pour mieux illustrer les mesures qui vont suivre, on prend pour point de départ le tableau suivant de classes de documents.

Tableau 1 – Les classes de documents

| Choisi | Refusé | Total | |

| Pertinent | Npc | Npr | Np |

| Non pertinent | Nnc | Nnr | Nn |

| Total | Nc | Nr | N |

On définit à partir des classes de ce tableau les mesures suivantes :

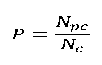

- Précision (« Precision ») : cette mesure représente la probabilité qu’un article choisi soit pertinent [6].

- Rappel (« Recall ») : cette métrique calcule la probabilité qu’un article pertinent soit choisi [6-9].

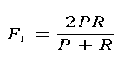

- F1 : cette mesure est une façon courante de combiner le rappel et la précision dans une seule métrique afin de faciliter la comparaison [6, 10, 11].

- Breese score : Breese et al. [12] proposent une extension à la métrique de Rappel appelée Breese score ou Rappel pondéré. L’idée principale sur laquelle repose cette métrique dérive du fait que l’utilité d’une recommandation se base essentiellement sur la probabilité que cette dernière soit consultée. Ainsi, cette mesure tient compte de l’ordre de présentation des recommandations en leur assignant différents poids. Pour ce faire, la métrique pénalise les n premières recommandations incorrectes, déterminées à partir d’une fonction appelée Breese-points, en leur assignant un poids fort et en diminuant de plus en plus ce dernier au fur et à mesure qu’on descend dans la liste de recommandations [3, 13].

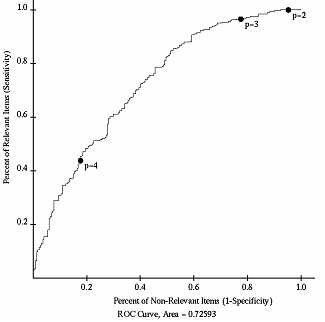

- La courbe ROC (« Receiver Operating Characteristic ») : une courbe ROC permet de comparer des algorithmes de recommandation indépendamment de la de la qualité des prédictions. ROC mesure le point auquel un système de filtrage de l’information peut distinguer avec succès les articles pertinents des articles non pertinents. De plus, cette mesure évalue l’ordre de présentation des recommandations (rang). Dans ce but, cette courbe met en relation dans un graphique, illustré par la figure 1, les taux de faux positifs (en abscisse) et les taux de vrais positifs (en ordonnée) [3, 14-18]. Une amélioration de la courbe ROC, notée CROC, a été proposée par Shein et al. [19].

Figure 1 – La courbe ROC [21]

- NDPM (« Normalized Distance-based Performance Measure ») : rarement utilisée, cette mesure, comme pour la courbe ROC, évalue l’ordre de présentation des recommandations. Plus précisément, cette métrique mesure la « distance » entre le rang de l’article dicté par l’évaluation de l’utilisateur et le rang prédit par le l’algorithme de recommandation [20].

Références

[1] C.-N. Ziegler, « Towards Decentralized Recommender Systems, » Albert-Ludwigs-Universitat Freiburg – Fakultat fur Angewandte Wissenschaften, Institut fur Informatik, 2005.

[2] P. Haase, A. Hotho, L. S. Thieme, and Y. Sure, « Collaborative and Usage-Driven Evolution of Personal Ontologies., » ESWC, vol. 3532, pp. 486-499, 2005.

[3] C.-N. Ziegler, S. M. McNee, J. A. Konstan, and G. Lausen, « Improving recommendation lists through topic diversification, » in Proceedings of the 14th international conference on World Wide Web Chiba, Japan: ACM, 2005.

[4] J. L. Herlocker, « Understanding and improving automated collaborative filtering systems, » University of Minnesota, 2000, p. 144.

[5] G. Adomavicius and A. Tuzhilin, « Toward the next generation of recommender systems: a survey of the state-of-the-art and possible extensions, » Transactions on Knowledge and Data Engineering, vol. 17, pp. 734-749, 2005.

[6] B. Sarwar, G. Karypis, J. Konstan, and T. J. Riedl, « Application of dimensionality reduction in recommender systems-a case study, » in ACM WebKDD 2000 Web Mining for E-Commerce Workshop Boston, MA, USA, 2000.

[7] B. N. Miller, J. A. Konstan, and J. T. Riedl, « PocketLens: Toward a personal recommender system, » ACM Trans. Inf. Syst., vol. 22, pp. 437-476, 2004.

[8] Z. Zaier, R. Godin, and L. Faucher, « Recommendation Quality Evolution Based on Neighborhood Size, » in Third International Conference on Automated Production of Cross Media Content for Multi-Channel Distribution. AXMEDIS ’07 Barcelona, Spain, 2007, pp. 33-36.

[9] Z. Zaier, R. Godin, and L. Faucher, « Recommendation Quality Evolution Based on Neighbors Discrimination, » in MCETECH Conference on e-Technologies Montreal, 2008, pp. 148-153.

[10] Z. Huang, H. Chen, and D. Zeng, « Applying associative retrieval techniques to alleviate the sparsity problem in collaborative filtering, » ACM Trans. Inf. Syst., vol. 22, pp. 116-142, 2004.

[11] M. Montaner, « Collaborative Recommender Agents Based on Case-Based Reasoning and Trust. » vol. Ph.D. Girona, Spain: Universitat de Girona, Girona, 2003.

[12] J. S. Breese, D. Heckerman, and C. Kadie, « Empirical Analysis of Predictive Algorithms for Collaborative Filtering, » Proceedings of the Fourteenth Conference on Uncertainty in Artificial Intelligence (UAI-98), pp. 43-52, 1998.

[13] M. Stritt, K. Tso, and L. Schmidt-Thieme, « Attribute-Aware Anonymous Recommender Systems, » in 30th Annual Conference of the Gesellschaft für Klassifikation (GfKl), Springer, Ed. Berlin, Germany, 2006, pp. 497–506.

[14] N. Good, B. J. Schafer, J. A. Konstan, A. Borchers, B. Sarwar, J. Herlocker, and J. Riedl, « Combining collaborative filtering with personal agents for better recommendations, » AAAI ’99/IAAI ’99: Proceedings of the sixteenth national conference on Artificial intelligence and the eleventh Innovative applications of artificial intelligence conference innovative applications of artificial intelligence, pp. 439-446, 1999.

[15] P. Melville, R. J. Mooney, and R. Nagarajan, « Content-boosted collaborative filtering for improved recommendations, » in Eighteenth national conference on Artificial intelligence Edmonton, Alberta, Canada: American Association for Artificial Intelligence, 2002.

[16] A. Schein, A. Popescul, L. Ungar, and D. Pennock, « Methods and metrics for cold-start recommendations, » Proceedings of the 25th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval (SIGIR 2002), pp. 253-260, 2002.

[17] M. Van Setten, M. Veenstra, A. Nijholt, and B. Van Dijk, « Case-based reasoning as a prediction strategy for hybrid recommender systems, » Second International Atlantic Web Intelligence Conference (AWIC 2004), vol. 3034, pp. 13-22, May 2004.

[18] E. Rojsattarat and N. Soonthornphisaj, « Hybrid Recommendation: Combining Content-Based Prediction and Collaborative Filtering., » INTELLIGENT DATA ENGINEERING AND AUTOMATED LEARNING: IDEAL, vol. 2690, pp. 337-344, 2003.

[19] A. I. Schein, A. Popescul, L. H. Ungar, and D. M. Pennock, « CROC: A New Evaluation Criterion for Recommender Systems, » Electronic Commerce Research, vol. 5, pp. 51-74, 2005.

[20] M. Balabanovi and Y. Shoham, « Fab: content-based, collaborative recommendation, » Commun. ACM, vol. 40, pp. 66-72, 1997.

[21] L. J. Herlocker, A. J. Konstan, G. L. Terveen, and T. J. Riedl, « Evaluating collaborative filtering recommender systems, » ACM Trans. Inf. Syst., vol. 22, pp. 5-53, 2004.